はじめに

今回の記事では、これまでに紹介してきた文献をグラフで可視化するツール「Research Rabbit」「Inciteful」「Connected Papers」の機能や特徴を整理し、比較していきます。これらのツールは文献同士の関係性をグラフで表示し、関連文献を効率よく探す手助けをしてくれるものですが、実際どのように使い分ければよいのか悩む方も少なくないと思います。

本記事では、それぞれのツールの概要と特徴を紹介した上で、実際に同じ文献を用いて比較・検証を行い、検索結果がどの程度一致するのかを探ってみます。各ツール間での検索結果のバラつきからその原因の考察、ツールの限界や注意点をみていきます。そして、それぞれの特徴を比較し、最後に実践的な使い方についても書いていきます。

いつも通り動画にてこれらの内容を実際の画面で紹介していますので、ぜひこちらもご覧ください。

文献のグラフ化ツールを初めて知る方は最初からみていただき、興味に応じて個々のツールの詳細記事を見てみてください。

すでにツールの大まかな使い方は知っている、という人は検索結果比較あたりから読んでいただくと良いと思います。

それでは見ていきましょう。

Research Rabbitの特徴まとめ

概要:

Research Rabbitは、検索した論文を「コレクション」というフォルダのような単位でまとめ、その中から関連する論文をグラフとして可視化できるツールです。複数の論文をコレクションに入れることで、引用・被引用関係や類似性のある文献を一望できます。

主な機能・利点:

- 複数論文のコレクションから関連文献を一気に探索可能

- Zoteroとの連携で文献データを簡単にインポートできる

- Similar Papers(類似論文)、Earlier Work(先行研究)、Later Work(後続研究)の分類で文献を表示

- キーワード検索でリストを絞り込み可能

注意点:

- 類似論文が多く表示されるため、網羅的ではあるが多すぎて処理しきれない可能性が高い

- 論文を次々とグラフ化し続けると、ブラウザ画面が際限なく広がり、管理が難しい

こんな場面におすすめ:

キーワード検索では行き詰まってしまい、既に確保している論文群から新たな関連文献を広げたい場合に有用です。

使い方の詳細を紹介した記事はこちら

Incitefulの特徴まとめ

概要:

Incitefulは無料かつシンプルなインターフェイスを持つ文献グラフ化ツールです。検索画面で論文を入力すると、関連文献のグラフとリストが表示されます。Bibtexファイルをアップロードすれば、一度に複数論文を取り込むこともできます。

主な機能・利点:

- Similar Papersの他、年代やキーワードで絞り込み可能

- 関連レビュー論文をまとめたリスト表示など、多面的なアプローチで関連論文を確認可能

- 被引用数が多い重要な論文を大きなノードで表示するなど、視覚的な優先度がわかりやすい

注意点:

- アブストラクトを見るには各論文ページに飛ぶ必要があるため、若干手間がかかる

- アカウント登録などがないため、コレクション保存機能はなし

こんな場面におすすめ:

分野に不慣れな段階で、レビュー論文から全体像をつかみたいときや、関連文献をカテゴリ別に絞り込みながら段階的に探索したいときに有効です。

使い方の詳細を紹介した記事はこちら

(補足)Zoteroを使ったbibtexファイルの出力

なお、これらのツールで使えるbibtexファイルをZoteroを使って出力する方法ですが

- ライブラリ画面でアイテムを複数選択(Shift + クリックもしくはドラッグして範囲選択)

- 右クリックで「選択されたアイテムのエクスポート」

- 「ファイルをエクスポート」にチェックをいれ、フォーマットでbibtexを選ぶ

- OKを押して出力先を選択する

これでbibtexファイルが出力されますので、そのファイルを使えばこれらのツールで文献を一気に取り込むことができます。

Connected Papersの特徴まとめ

概要:

Connected Papersは無料版で月5回までグラフ生成が可能なツールです(それ以上は有料)。単一論文からグラフを生成し、そこに表示された論文しか追加できないため、やや自由度が低い点が特徴的です。

主な機能・利点:

- グラフ上で、関連性の強い論文ほど近接して配置

- Similar Articles、Prior Works、Derivative Worksといったカテゴリー分けで関連文献を提示

- UIがシンプルでわかりやすく、アブストラクトやTL;DRを素早く確認可能

注意点:

- 無料版はグラフ生成が制限的で、有料利用を前提に考えたほうがよい

- 単一論文ベースでしかグラフを作れないため、複数論文を同時に扱いたい場合は不向き

こんな場面におすすめ:

関連文献をより厳選して短時間で確認したい場合や、過度な情報量を避けたいときに有用です。

表でのまとめ

これらのツールの特徴を簡潔に表でまとめました。 また詳細は各記事を参照していただきたいと思います。

検索結果の比較・検証

今回、ツールを比較するうえで気になった点は、「同じ文献を異なるツールで検索したとき、どれくらい結果が一致するのか」という点です。

そこで今回医学系論文での検索結果の比較を行ってみました。

検証方法:

- 共通の論文を決め、Research Rabbit, IncitefulとConnected Papersで検索

- 得られた結果をBibtex形式でリストとして出力し、Pythonで解析

- リストの中で重複している文献数を計測して、一致率を確認

- また、connected papersでは類似性のスコアがあるため、スコアがどれくらいの論文が各ツールで合致しているのかも確認

検証対象とコード:

- 対象論文は医学系で、臨床系レビュー、臨床研究、基礎研究の3パターンを用意

- IncitefulではSimilar Articles上位50本、Connected Papersは41本、ResearchRabbitでは上位100本の検索結果を使用

- ちなみに具体的な対象論文は以下となっています。ある程度内容を自分が知っている論文を適当に選びました。

【臨床レビュー(というかposition paperなのでちょっと違いますが) 】

Graus, F., Titulaer, M. J., Balu, R., Benseler, S., Bien, C. G., Cellucci, T., ... & Dalmau, J. (2016). A clinical approach to diagnosis of autoimmune encephalitis. The lancet neurology, 15(4), 391-404.

【臨床研究】

Rossetti, A. O., Schindler, K., Sutter, R., Rüegg, S., Zubler, F., Novy, J., ... & Alvarez, V. (2020). Continuous vs routine electroencephalogram in critically ill adults with altered consciousness and no recent seizure: a multicenter randomized clinical trial. JAMA neurology, 77(10), 1225-1232.

【基礎研究】

Shi, Y., Zhang, W., Yang, Y., Murzin, A. G., Falcon, B., Kotecha, A., ... & Scheres, S. H. (2021). Structure-based classification of tauopathies. Nature, 598(7880), 359-363.

- なお、使用したpythonコードは以下です。ツール毎にBibtexの内容が微妙に異なるので、テキストタイトルの合致をチェックしました。

import re

# .bibファイルをテキストとして読み込み、タイトルを抽出する関数

def extract_titles_from_bib(file_path):

with open(file_path, 'r', encoding='utf-8') as file:

bib_content = file.read()

# エントリからtitleフィールドを抽出する正規表現

titles = re.findall(r'title\s*=\s*\{([^}]+)\}', bib_content, re.IGNORECASE)

# タイトルのリストを返す

return [title.strip() for title in titles]

# 2つの.bibファイルを読み込み、タイトルを比較

def compare_titles(file1, file2):

titles1 = set(extract_titles_from_bib(file1))

titles2 = set(extract_titles_from_bib(file2))

# 一致するタイトルを取得

matching_titles = titles1.intersection(titles2)

# 結果を表示

print(f"ファイル1の文献数: {len(titles1)}")

print(f"ファイル2の文献数: {len(titles2)}")

print(f"一致する文献数: {len(matching_titles)}")

print("一致する文献のタイトル:")

for title in matching_titles:

print(title)

# 使用例

compare_titles("1.bib", "2.bib")

さて結果を以下に並べておきます。

まずIncitefulとConnected Papersのリストの比較結果です。合致している論文数は以下でした。

| カテゴリー | 合致した論文数(Incitefulの%, Connected Papersの%) |

|---|---|

| 臨床レビュー | 8 論文 (16.0%, 19.5%) |

| 臨床研究 | 14 論文 (28.0%, 34.1%) |

| 基礎研究 | 17 論文 (34.0%, 41.4%) |

カテゴリによってばらつきがありそうですが、少なくとも半分には満たないですし、結構合致していないことが分かります。

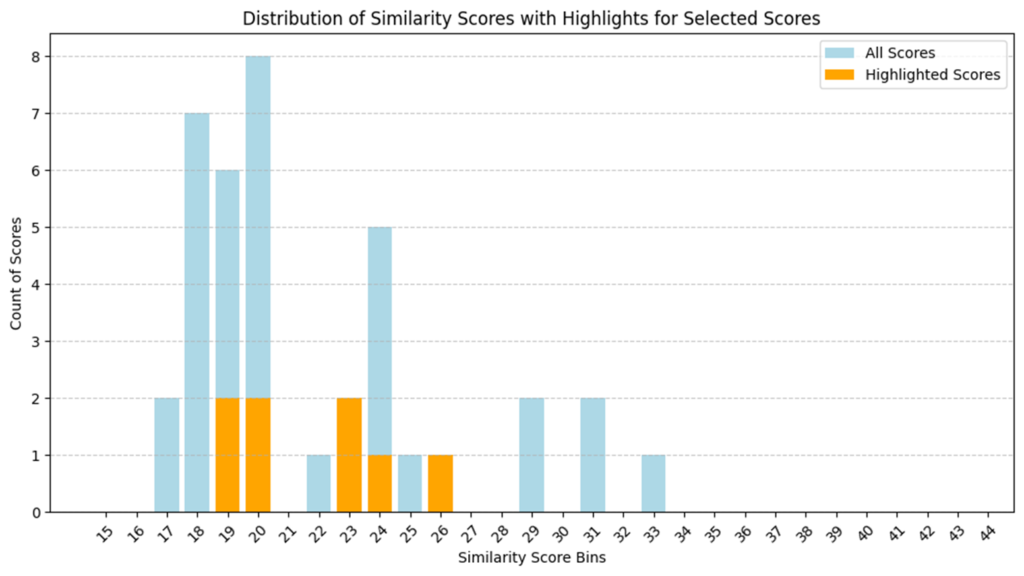

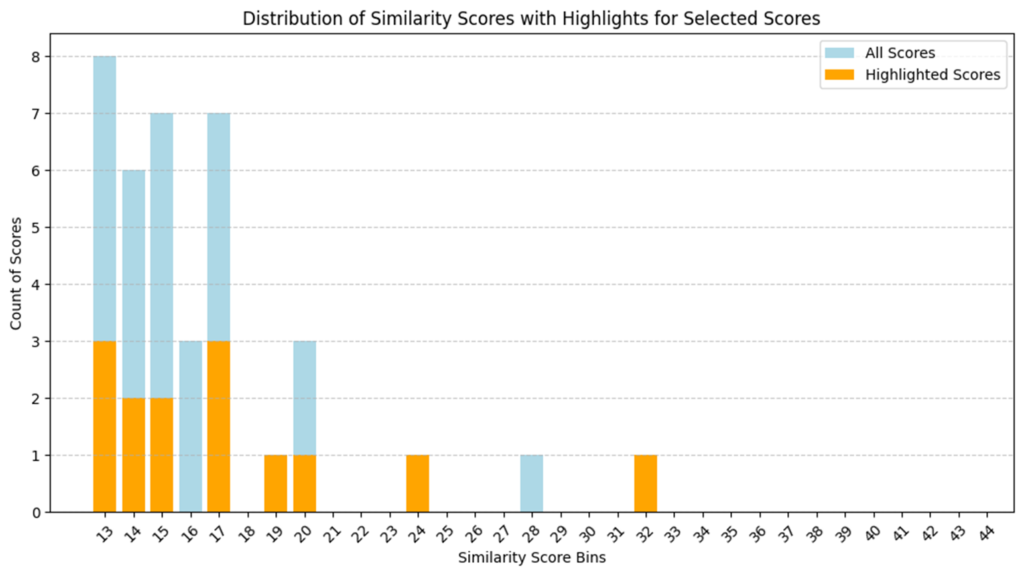

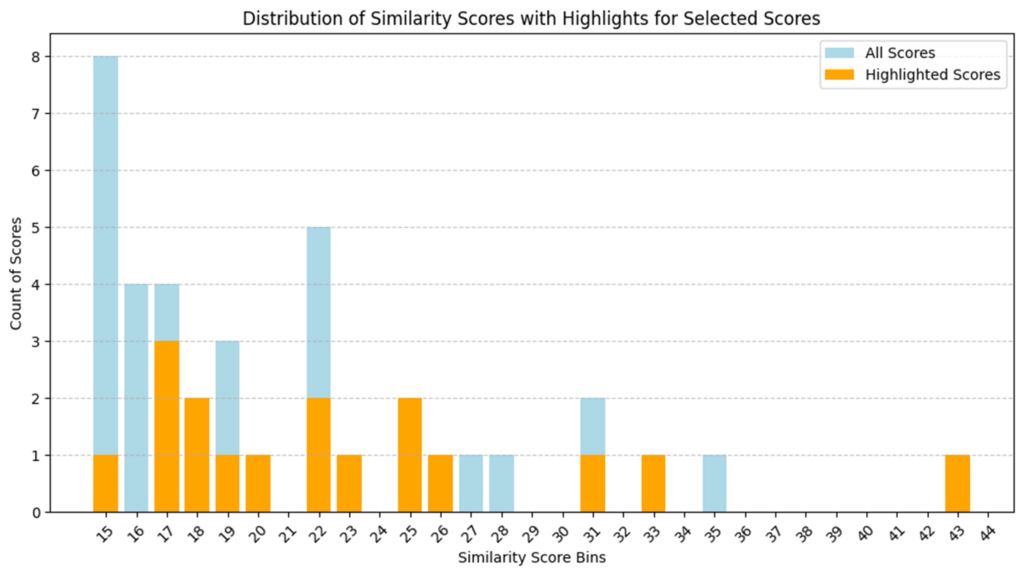

ここで、合致した論文がConnected Papersにおける「類似性のスコア」のうちどの辺に該当するのかを棒グラフにしてみました。

水色のグラフがConnected Papersで出てきたすべての論文のスコアの分布で、オレンジ色がそのうちIncitefulでも出てきた論文の分布になります。

これをみることでIncitefulでもConnected Papersでも引用的な関係性が深い論文を逃さずにカバーできているのかどうかが分かります。右の方のスコアが高い部分でオレンジ色が多ければ、Incitefulがカバーできているということになります。結果は以下の様でした。

【臨床系レビュー】

【臨床研究】

【基礎研究】

臨床系レビュー以外はそれなりにカバーできているようにもみえますが、なんだかんだでオレンジ色の部分はばらつきがありそうです。重要な論文は漏らさずカバーできている、と断言するのは難しそうですね。

続いて、Research Rabbitと他のツールの合致を見てみます。ここまでの結果が芳しくなかったこともあり、Research Rabbitでは出力数を100に増やしてみてみました。

| カテゴリー | 合致した論文数(ResearchRabbitの%, Connected Papersの%) |

|---|---|

| 臨床レビュー | 9 論文 (9.0%, 22.0%) |

| 臨床研究 | 7 論文 (7.0%, 17.1%) |

| 基礎研究 | 4 論文 (4.0%, 9.8%) |

| カテゴリー | 合致した論文数(ResearchRabbitの%, Incitefulの%) |

|---|---|

| 臨床レビュー | 2 論文 (2.0%, 4.0%) |

| 臨床研究 | 2 論文 (2.0%, 4.0%) |

| 基礎研究 | 4 論文 (4.0%, 9.7%) |

これがなかなかひどく合致していないですね。どうもResearchRabbitで出てくる文献の順番がどうやら一癖ありそうな雰囲気がします。特にincitefulとResearch Rabbitは合致度合いが低いようです。

これらをみてみると想定よりも一致率は低く、どのツールを使っても出てくる文献が必ずしも大きく重複するわけではないことがわかりました。

特にレビュー論文から広げる場合は、あまり重複しない傾向が強く、特定のツールだけでは網羅性を期待しにくい結果となりました。 今回は単一の論文で基本的に検索しており、本来のこれらのツールの使い方とは異なる可能性があり、論文数を増やせばもっと合致してくる可能性はあります。

ただうまく内容が重複した論文でなければグラフ化で出てくる論文の絞り込みに働かない可能性もあるので、やはり入力する論文次第というところはあると思います。 少なくとも少数の論文から似たような結果を導き出すのは難しいのではないでしょうか。

なぜこのような違いが生じたか

なぜこのような差が生じるのか?というところを公式ページのデータベースや説明を参考に考察してみました1。

- 引用データベースの違い:

- Research RabbitはOpenAlexやSemantic ScholarIncitefulはOpenAlex, Crossref, Semantic Scholar, OpenCitationsConnected PapersはSemantic Scholar

- アルゴリズムの違い:

- IncitefulはPageRankを明示的に使用他のツールも類似手法を用いている可能性があるが明示されていない

- そもそも生命医学系論文は引用数と絶対数が多い:

- 特に今回はレビュー系で合致しにくい結果が出ていましたが、引用数が多ければばらつきも生じやすくなります

- ものすごく影響力が大きいものがあれば別ですが、候補が多数あればあるほどアルゴリズムごとにばらつく可能性があるのではないでしょうか

これらの結果と原因を考慮すると、引用関係をみれば自ずと重要な論文が絞り込める、というのはやはり難しいのではないかと思います。

実践的な活用例

ここまでの比較と検証をまとめて、実際の使い方を検討してみたいと思います。

まず、前提としてツール毎の検索の検証結果から察するに一つのツールで包括的に文献が網羅できる可能性というのは低いかなと思います。

なので、ツールの特徴を踏まえて、場面ごとに使い分けるような方法を考えてみます。

- スタートラインでの活用:

分野全体像を掴むため、IncitefulやConnected Papersを使ってレビュー論文や代表的な研究を拾い、関連領域をチェック。

これらのツールは出てくる論文の全体数も少な目あるいは絞り込まれているため、迷子になりにくいです。 - キーワード検索との併用:

気になる論文やキーワードがいくつか揃ったら、キーワード検索やAIツールを組み合わせ、さらに関連文献を探索します。

以前紹介したAIツールは1の段階でも役立つと思いますし、この2の段階で気になるワードを深掘りする際にも使えると思います。下にリンクを貼っておきます。

ここで出てくるキーワードが結構ニッチな領域であった場合は、通常のデータベースでキーワード検索をした方がより網羅的にいい文献が見つかる可能性が高いです。 AIツールで検索したときに「コレジャナイ感」のある論文ばかり出てくる場合は、キーワード検索に移った方が良いでしょう。 - Research Rabbitでの深掘り:

十分な文献が集まり、ある程度キーワードが明確になった+論文が複数集まってきた段階でResearch Rabbitを使い Zoteroで集めた論文群からさらに新たな関連文献を発掘するのが良さそうです。 ただ必要に応じて1,2に戻るのも当然ありだと思います。

このような流れでツールを組み合わせることで、各ツールの特性を最大限に活かし、効率的な文献探索が可能になるのではないでしょうか。

また研究者の皆さんの実例もコメント欄などで教えていただけると嬉しいです。

まとめ

今回の内容をまとめてみます。

- 3ツールの特徴:

- Research Rabbit:豊富な検索結果とZotero連携が魅力。深掘りに向く。

- Inciteful:多面的なリスト表示で、分野の概観や新規分野の探索に有用。

- Connected Papers:シンプルなインターフェイスで厳選された文献群を提示。

- 検証結果の要点:

各ツール間で検索結果は思ったほど一致せず、特にレビュー論文を起点とした場合は網羅性と再現性が低下しやすい。 網羅的にすべてをみられるツールというのは今のところない。 - 使い分けの提案:

IncitefulやConnected Papersで分野の全体像を把握し、ある程度絞れた段階でResearch Rabbitを用いてさらなる関連文献発掘を行うのが個人的なおススメです。

膨大な山のような論文がある中で万能、爆速というツールはやはり存在しないんだなとしみじみ思います。 とはいえ引用関係を洗い出すのは大事かつ大変な作業であり、それを補助してくれるこれらのツールは使うに越したことはないと思っています。

LLMをベースにしたツールと同様に利点欠点を把握しつつ、使っていくのが大事だと思いますので、まだあまり使っていなかったという人はぜひどんどん使ってみてください。

参考ページ

- https://researchrabbit.notion.site/Welcome-to-the-FAQ-c33b4a61e453431482015e27e8af40d5

https://inciteful.xyz/data

https://www.connectedpapers.com/about ↩︎

コメント