さて、ここ最近文献検索を行うための大規模言語モデルによるAIツールを立て続けに紹介してきました。

今回はここまで紹介してきた4つのツール(Scispace, Perplexity, Elicit, Consensus)について総まとめとしてそれぞれを比較し、注意点や使用上のおすすめポイントをまとめて紹介していきたいと思います!

今までぼんやりと使っていた時は何となくどれも似たようなものかと思っていたのですが、思いのほか特徴や使用感が異なりますので、特徴を踏まえたうえで自分の研究に役立ててもらいたいです。

これまでどのツールを使ったこともないという人にも、どれが一体おすすめなのか、分かるように解説していくつもりなので、ぜひ最後までご覧ください。

また毎度のごとく、使用感の分かりやすい動画での解説もしていますので、良ければこちらもどうぞ。

ではそれぞれ見ていきましょう。

大規模言語モデルによる文献検索のためのAIツールとは?

最初に、そもそも今回まとめているツールはどのようなものなのか、何の役に立つのか、簡単に説明します。

ChatGPTやClaudeなどで有名になった大規模言語モデルによるAI。これらは膨大な文章情報のデータをもとにして、機械学習を行い、言語の生成やインプットした言語情報の処理、識別などを行うものです。生成AI(generative AI)という単語も最近ニュースで良く使われますが、それはテキストのみならず、画像や音楽、コードなど様々なものを生み出すAIの総称で、大規模言語モデルに基づくAIはその一種ということになります。

研究者として文献を調べることは日常的かつ重要な業務の一つです。研究者は過去の知見に基づいて、新規の研究を進める必要がありますし、医師であれば知見を参考にしながら治療の方針や診断を検討します。しかしながらそれにはかなりの時間がかかります。

調べる対象となる文献の数は増えていく一方ですし、実際システマティックレビューやメタ解析と呼ばれる厳密な手法で文献を調査するには長大な時間を要します(2017年の研究では平均67.3週!ただこれは計画から出版までなので査読も含めてですが)1 2。

もちろん時間をかけてまとめられたシステマティックレビューや専門家による合意のもとで形成されたガイドライン、成書はこうした調査の時間を大きく節約してくれますが、すべての事象についてまとめることはできず、また時間がかかるため、最新の情報は得られません。

そこで、役に立つのが大規模言語モデルによるAIです。文献情報は基本的にテキストデータですし、幸い文献情報は様々なデータベースにまとめられていますので、学習するためのデータセットも膨大にあります。これらを学習したモデルを使うことで、pubmedなどの通常のデータベースで行うようなキーワード検索ではなく、質問のような文章で関連した論文を導き出したり、多数の文献の内容を簡潔にまとめたり、あるいは一つの論文について簡潔に内容を要約したり、してもらうことができます。

例えば、キーワード検索では単語間の関連性を著述することができません。Aという病気の原因としてBというタンパク質が関連するか?というのは"A", "B"という単語の記載しかできないため、因果関係は書けないということです。こうした質問も可能となるのは大規模言語モデルによるツールならではと言えるでしょう。そして内容を簡潔にまとめてもらうことで、必要に応じた文献を選別する時間は短縮されます。これらが文献検索ツールを使う大きな目的です。

しかしながら、まだまだこうしたツールは新しく、調べて出てきた回答や文献の妥当性は明らかにはなっていません。データベースが今後も新しくなっていくことを考えると、おそらく今後も確実に安心といえるようなことはないでしょう。そのため、各研究者がある程度ツールの特徴や使い方を把握しながら使うことが必要になってくると思います。そこで、ツールの理解と学習を進めるべく今回はこのような記事を書いてみました。以下より早速まとめていきます。

Scispace, Perplexity, Elicit, Consensusの比較まとめ

今回は比較的よくみられる代表的なツールとしてScispace, Perplexity, Elicit, Consensusの4つについてまとめてみました。文献管理に関するツールはまだまだ多数ありますが、主に大規模言語モデルを使った文章による文献検索ができるツールに絞ってまとめています。

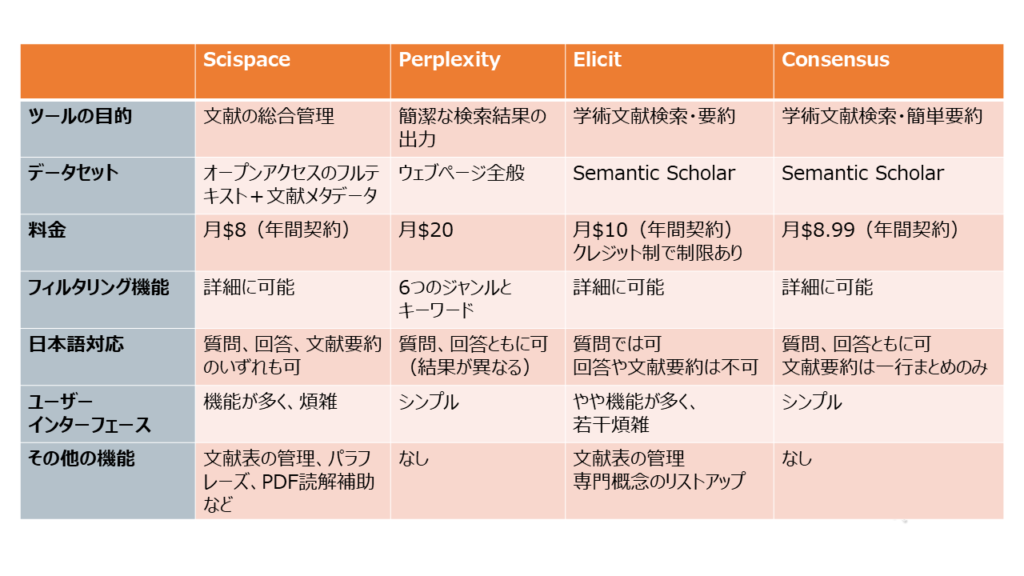

早速それぞれの比較を表にしてまとめてみます。

なお、それぞれの細かい内容や使い方は各記事に書いておりますので、興味があればご覧ください。

表の内容について以下で簡単に説明していきます。

ツールの目的

まず、最上段は各ツールの目的です。

個々のツールのアルゴリズムは場合によっては他のモデル(ChatGPTなど)に依存している場合がありますし、詳細に理解することは私も難しいのですが、ツールがどういったことを目標にしているかが分かれば、どんな出力を目標としているのかが何となくわかります。

出てきた文献の妥当性を考えるには自分の検索したい内容と合っているのかどうか確認することが大事ですね。

例えば、Perplexityは「簡単で理解しやすい検索結果の出力」が目的ですので、文献の網羅性は少なくとも得られにくいことが分かります。

この辺りは各公式ページの"About"をみると分かりやすいでしょう。

データセット

次に「データセット」です。大本にどのようなデータがあるのかは出てくる結果の解釈や不足している部分に気づくことに役立ちます。

例えばElicitやConsensusはSemantic Scholarという文献データベースをもとにしていますが、Semantic Scholarに含まれていないような文献を見つけ出すことは当然できません。また、Perplexityはウェブ全体を対象としており、出てくるものにも通常のウェブサイトが含まれ得ることがわかります。

料金

どのツールも概ね月額料金が必要となるサブスクモデルです。Elicitのみクレジットというポイント制があり、機能を使用すればするほど消費する形となっています。

月契約よりも年間契約が安いという事も多いですね。

日本語対応

日本語での質問や回答、文献要約に対応しているかどうかです。ほとんどのツールが大規模言語モデルを使用しているため、それによる翻訳機能が備わっています。ただし、注意が必要なのは、多くの文献やツールが英語をベースにしているため、翻訳の際にうまく伝わらなくなる可能性がある点です。特に専門用語などの一般的な翻訳が定まらない概念についてはそうした齟齬が起きやすいと言えます。

また、Perplexityでは英語の検索と日本語の検索で内容が異なりますので(Google検索で日本語と英語の検索が違うのと同じ印象です)、そこに留意しながら検索機能を使う必要があります。

ユーザーインターフェース、その他の機能

ツールの画面の使いやすさ、分かりやすさと文献検索以外の機能についてです。

今回は文献検索の機能に着目していますが、多くのツールが他の機能も持っていますので、そこを使い分ける際の分かりやすさをみています。例えば、Scispaceは特に機能が多い分、初見では機能を把握しにくい印象があります。

この二つはトレードオフの関係になりがちです。

各ツールの簡単な紹介

では続いて各ツールについて文献検索機能を中心に、ごく簡単に紹介していきたいと思います。

Scispace

Scispaceは文献検索から読解・管理、論文執筆までを総合的に支える機能を持ったツールです。文献検索機能については質問によって回答と引用文献の表を生成するスタイルとなっています。機能としては申し分ないのですが、オープンアクセスデータが多いためか、出てくる論文に偏りがあるように感じる点が難点です。領域によるかもしれませんが、臨床医学系の質問ですと、正直質として微妙な研究が引用されることも多かったです。無料のユーザーで1日5回まで検索できるので、色々試してみるのが良いと思います。

無料アカウントでも引用文献の表要約の生成や自分がアップロードした論文の表要約の生成ができますので、それ以外も含めると活用の幅が広いです。また、PDFリーダーもcopilotを使って簡単に使えますので、英語論文の部分的な要約や数式・表の説明などもやりやすいです。

Perplexity

Perplexityはウェブ検索を簡潔にまとめるためのツールで学術文献以外にも使用用途が広いツールです。検索対象をウェブ全体から学術文献に絞るfocus機能があり、Academicという領域を選べば、学術文献に絞った検索もできます。ただ、Academic機能は対象が少ないと引用をしてくれないときがあるので、その場合はAllという通常の検索をするか、もしくは質問文の末尾に「ソースも引用してください。」と指示を入れると良いです。ただし、当てはまる文献があまりないときは無理やりあまり関係ないソースが出てくることもありますので注意が必要です。

引用する文献も通常の無料の検索では5個までなので、網羅的に文献を検索することには向きません。また出てくる文献もresearch articleのような一次情報ではなく、reviewやSemantic ScholarによるTL;DRという要約であることが多いです。あくまで質問したい領域の概観を知ったりする目的に使うのが良いでしょう。

文献検索ではありませんが、学術用語について調べたり学ぶのにもかなり有用だと思いますので、検索→ソースを読む、というのを繰り返すだけでもかなり役立ちます。

Elicit

Elicitは学術文献専門の検索ツールで、表にしてまとめながら文献にどんどん出会うことができます。質問による検索のほか、追加質問やフィルタリング機能、またトピックに関連した用語の洗い出しなど、文献の幅を広げていく機能が充実しています。しかしながら2024年現時点で難しい点は回答が英語しかないことと何をするにもクレジット(ポイントのようなもの)が必要で、基本的には有料会員にならないと細かく色々試せない点でしょう。

(※2024年8月現在、更新されたようで、課金した場合にクレジットによる制限がなくなったようです)

データセットがSemantic Scholarという学術専門のデータベースである分、質としてはある程度良いのですが、どうしても使用面でクレジットがかかることが制限になってしまいます。

Consensus

Consensusは学術文献の検索のみに特化したツールです。質問に対して合わせた文献を提示してくれます。個々の文献は1~2行での簡潔なまとめと、研究デザインが見やすく、読む論文を選抜するのも楽にできます。また、出てきた文献の内容をまとめて質問に対する回答を生成する機能(Synthesize)や質問に対して引用をしながら回答してまとめる機能(Copilot)も新規に追加されてきており、上述のツールとも遜色なく使用できます。

データセットがSemantic Scholarであり、回答の質としてもまずまず良い印象があります。加えて検索機能は無料でもどんどん使えるので、使用感も十分試しながら有料会員とするかどうか吟味できます。

共通の使用上の注意点

さて、ここからはそれぞれのツールを使ってみたうえで共通して注意しておきたい点を書いておきます。あくまで個人的な意見です。

回答のサマリはあてにしない

生成AIでは定番の話かもしれませんが、文献の引用を使っているとはいえ、出てくる回答の内容はあまりあてにし過ぎない方がよいでしょう。

まず一つにはhallucinationと言われる事実ではないことを述べている問題があります。引用した文献を読んでみても、そこで述べられていたようなことが書いていないケースも散見されました(特にPerplexityでウェブサイトの引用において稀にあった印象です)。文献を引用する生成AIの意義というのは、引用しているから精度が高いということではなく、文献を読むことでその事実の有無を確認できるという点が一番だと思っています。そこで得た知識を他で使う際は必ず引用している文献やウェブサイトを見るべきです。

また、引用している内容が書いてあったとしても、大きな文脈を無視して切り抜いているだけのケースもあります。例えばAという薬の動物実験があったときに、考察で「Aという薬はBという病気に有効である可能性がある」なんていうことはよく論文の価値を高めるために書かれているわけですが、人が読む場合は「動物実験レベルだから本当に有効かは分からないけど、論文の意味を主張するためにはお決まりの文句だよね」というのが分かるわけです。ところが今回のツールではそれを真面目に「有効性がある可能性があります」といって引用していることがあります。間違ってはないのかもしれませんが、他にももっと重要な人のデータがあるのに、それを引用しないケースも目立ちますので、背景を広く加味した価値の重みづけをするのには適していないことがあります。

こうした問題点が多くありますので、ツールで質問した内容と回答に基づいて臨床医学にそのまま応用するなんていうのは(やる人もいないとは思いますが)当然厳禁です。

網羅性の問題

最初に出した各ツールの記事を見ていただくと分かるのですが、今回同じ臨床医学の質問をそれぞれのツールに投げかけて回答や出てくる文献を吟味しています。そこで、出てきてほしい論文の一つにコクランデータベース(厳密な手順に沿ったシステマティックレビューとメタ解析のデータベース)による論文があったのですが、これに関してはなぜかどのツールで検索したときにも出てきませんでした。元のデータベースには存在しているのに、何ならタイトルをそのまま検索してみても発見できないことがありました。

理由はよくわかりませんが、キーワード検索と異なりどうしても拾い上げにくい部分があるようで、文献の網羅性には不安が残ります。

システマティックレビューの労力を減らすために大規模言語モデルを使った研究はちらほらとみられますが、レビューなどを見ている印象では特異度よりも特に感度が低い印象があります。質問に合致したものを見つけるのは得意でも見逃してしまうことは多々あるようです3 4。

重大な文献を見落とされてしまうと研究をするうえでは致命傷なので、PubmedやWeb of Scienceなど通常のキーワード検索ができるデータベースでの検索や二次情報の引用文献を細かに読むような作業は変わらず必要と言えるのではないでしょうか。

使用する用語やプロンプトの問題

内部のアルゴリズムやデータと同様に重要なのはインプットです。

どのような専門用語を使用するか、質問文を使用するかによって回答は常に変化します。検索は一発でおしまいというわけにはいかず、調べて文献を読むことで知った用語をうまく使ったり、質問の仕方を変えることで知りたかった内容が得られることもあります。類似した質問をレコメンドしてくれるツールも多いので、それを使ってみるのも良いと思います。

ただ、あまりにも検索を繰り返しているとかえって時間を浪費するのではないかという気もしますのでこの辺のバランスが難しいところです。

また、こうした質問によって逐一結果が変化してしまうので、キーワード検索と異なり、再現性を得にくいところも困る点です。やはりAIツールは網羅的な検索には向いていないように感じます。

まとめと使い方の検討

4つのツールを比較しつつ、それぞれが共通して持つ使用上の注意点とともにまとめてみました。

いずれのツールも一長一短ありますが、まだシステマティックレビューができるほどの文献の選抜精度はないと思いましたので、これらのツールはこれから知りたい領域の概観を知る程度に使うのが良いのではないでしょうか。

研究が広がりを見せ、新しい分野について知りたいときに、キーワード検索で出てくる文献をしらみつぶしに探すのは非常に大変です。Reviewであってもそれが多数ある領域ですと、どれを読んでよいか困ります。そんなときにざっと内容をまとめてくれたり、自分の質問に合うものを適切に絞り込んでくれるのは大いに助かります。

特に個人的にはConsensus, Perplexity辺りがこの用途で使いやすいと思いました。Consensusは無料でも検索機能を繰り返し利用でき、研究デザインによるフィルタリングもある程度はできますので、関係する文献を拾いやすいですし、Perplexityはウェブ全体から広い視野でその領域に関するレビューや内容を見つけてくれます。

そこからは文献を手掛かりに少しずつ広げていくしかないと思いますが、続いてはResearch Rabbit, Connected Papers, Incitefulなどの関連論文をグラフで可視化して洗い出すようなツールが役に立つと思います。

旧ブログでの記事がすでにありますが、また改めて作り直していく予定なので、またぜひ見ていってください。

現時点で想定される使い方としては

①知りたい分野の用語や質問を考える

②今回紹介したツールで文献検索する

③新たな疑問を抱えつつ、関連論文を洗い出す

④2,3を繰り返して理解の精度を上げる

といった感じでしょうか。

もし、この記事をご覧になった皆さんも「こんな使い方があるよ」とか「こんな風に使ってます」とかがあればぜひコメント欄、Xなどで共有してみてください。

では、次回からは論文の関連性をグラフで可視化するツールについて見ていきたいと思います。

蛇足:今後も出てくるであろうツールについて見るポイント

蛇足ですが、日進月歩のAI領域で「AIを使った〇〇が最強です」みたいな記事やポストをよく目にします。

基本的に本当に「これが最強」みたいなのはそうそうないので、使うときは本当に自分の役に立つのかよく吟味した方が良いと思います。そこで、今後もたくさん出てくるであろう文献検索ツール達に出会ったときに、落ち着いてみておきたいポイントをまとめておきます。

- ツールの目的について知る 本当は内部のアルゴリズムを理解できるのが一番だと思うので、それはそれで勉強しておきたいのですが、それが分からないうちはまず製作者の意図を理解しておくのが良いなと思いました。特に大規模言語モデルを使ったAIは便利なのでどんな質問でも答えを出力してくれてしまうのですが、目的に合った使い方でないと結果も少し意図からずれたものとなってしまうことがあります。ツールの使い方・目的については英語で分かりにくかったとしても、公式のサイトに目を通すことが大事です。

- 何のデータを元にしているかを知る なんのデータセットを元にしているかも同じように重要な点です。自分が知りたい対象としているものなのかどうか、結果の妥当性がどうかを吟味するうえで欠かせません。特に学術領域の場合、これが明示されていないようなものは信頼性に欠くといってもいいと思います。

- とにかく自分が既にある程度まで知っていることを試してみる 今回臨床医学の質問をそれぞれのツールに投げてみましたが、その回答の違いによって、何となく傾向が分かりました。すでに自分が知っている分野であれば「どの情報が重要か」あるいは「どの情報が重要でないか」がある程度ネットワークとして自分の頭の中にあると思います。もちろん自分に必要な情報が欠けている場合もありますが、追加して調べながらでもいいので、知っていることをとにかく試してみるのが、ツールの妥当性をみていくうえで大事です。

AIのツールはまだまだ発展途上ですので、この記事も1年後くらいにはまた見直していきたいと思います。どうしても新規性とバズ狙いの喧伝が多くなりますが、こうしたツールについて見るべき点など思うところがありましたら、こちらもコメントいただけると嬉しいです。

- Borah, Rohit, Andrew W Brown, Patrice L Capers, and Kathryn A Kaiser. “Analysis of the Time and Workers Needed to Conduct Systematic Reviews of Medical Interventions Using Data from the PROSPERO Registry.” BMJ Open 7, no. 2 (February 2017): e012545. https://doi.org/10.1136/bmjopen-2016-012545. ↩︎

- Bornmann, Lutz, Robin Haunschild, and Rüdiger Mutz. “Growth Rates of Modern Science: A Latent Piecewise Growth Curve Approach to Model Publication Numbers from Established and New Literature Databases.” Humanities and Social Sciences Communications 8, no. 1 (October 7, 2021): 224. https://doi.org/10.1057/s41599-021-00903-w. ↩︎

- Khalil, Hanan, Daniel Ameen, and Armita Zarnegar. “Tools to Support the Automation of Systematic Reviews: A Scoping Review.” Journal of Clinical Epidemiology 144 (April 2022): 22–42. https://doi.org/10.1016/j.jclinepi.2021.12.005. ↩︎

- Oami, Takehiko, Yohei Okada, and Taka-aki Nakada. “Performance of a Large Language Model in Screening Citations.” JAMA Network Open 7, no. 7 (July 8, 2024): e2420496. https://doi.org/10.1001/jamanetworkopen.2024.20496. ↩︎

コメント